Tìm hiểu file Robots txt trong SEO là gì?

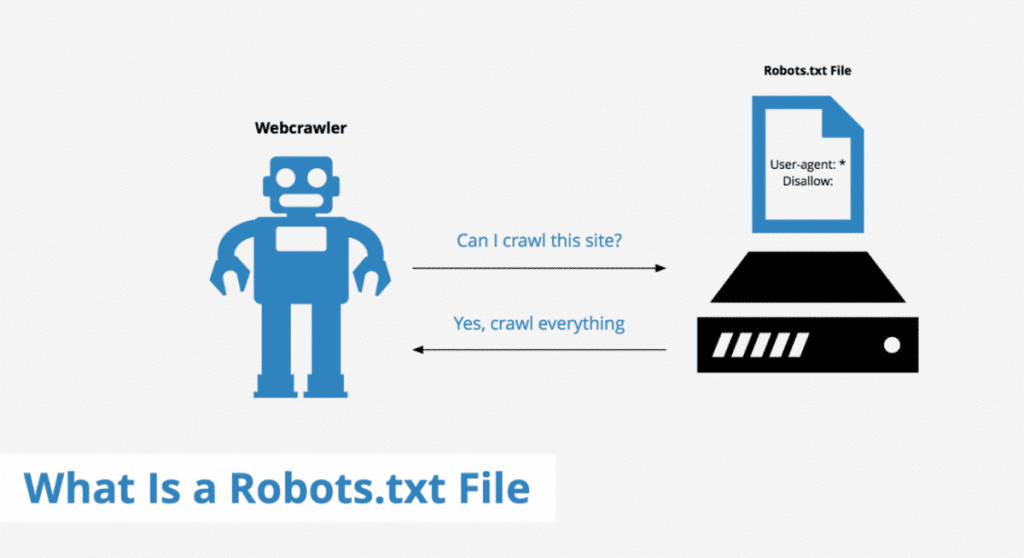

Robots.txt là nơi để quản trị website của bạn để cấu hình hướng dẫn robot web (thường là rô bốt công cụ tìm kiếm của Google), thu thập dữ liệu trên web, truy cập, index nội dung và cung cấp nội dung đó cho người dùng. Robots txt nói 1 cách đơn giản Robots.txt một tập tin văn bản đơn giản có dạng .txt, đặc biệt nó không phải là file HTML hay một loại nào khác cả.

Khái niệm file Robots txt là gì?

Robots.txt là một tệp tin văn bản để quản trị website, nằm trong thư mục gốc của trang web và cung cấp hướng dẫn cho các công cụ tìm kiếm thu thập thông tin về các trang mà họ có thể thu thập thông tin để lập chỉ mục.

Khi truy cập vào trang web, điều trước tiên công cụ tìm kiếm là phải tìm kiếm và kiểm tra nội dung của tệp robots.txt. Có trường hợp tùy vào những quy tắc được chỉ định trong tệp mà chúng tạo ra các danh sách tệp URLS có thể thu thập dữ liệu và sau đó lập chỉ mục cho trang web.

Nội dung của tệp robots.txt được công khai trên Internet. Bất kì ai cũng có thể xem nội dung của tệp robots.txt vì vậy đây không phải là nơi để các bạn thêm nội dung mà bạn không muốn người khác xem.

Định dạng cơ bản của File Robots

Định dạng cơ bản của File Robots

User-agent: [User-agent Tên của search engine mà bạn muốn điều khiển]Disallow: [URL chuỗi không được thu thập dữ liệu]

Cú pháp của File Robots txt là gì?

Cú pháp Robot.txt có thể được xem là ngôn ngữ của các tập tin robot.txt, và có 5 thuật ngữ phổ biến mà bạn có thể gặp trong 1 file Robot bao gồm:

- Disallow: Là khu vực mà bạn muốn khoanh vùng không cho phép search engine truy cập.

- Crawl-delay: Thông số này xác định thời gian (tính bằng giây) bots phải đợi trước khi chuyển sang phần tiếp theo. Điều này sẽ có ích để ngăn chặn các search engine load server tùy tiện.

- User-agent: Khai báo tên của search engine mà bạn muốn điều khiển, ví dụ: Googlebot, Yahoo!, Bingbot,…)

- Sitemap: Lệnh này được sử dụng để cung cấp các vị trí của bất kì XML sitemap nào được liên kết với URL này. Lưu ý lệnh này chỉ được hỗ trợ bởi Google, Ask, Bing và Yahoo.

- Allow (chỉ áp dụng cho Googlebot): Lệnh này thông báo cho Googlebot rằng nó có thể truy cập một trang hoặc thư mục con. Mặc dù các trang hoặc các thư mục con của nó có thể không được phép.

File Robot txt có ý nghĩa gì trong SEO

Tại sao nên phải sử dụng Robots.txt

File Robots.txt trên website wordpress giúp bạn có thể kiểm soát được việc truy cập của các bot đến các khu vực nhất định trên trang website của mình.

Bên cạnh đó, nó giúp ngăn chặn những nội dung trùng lặp xuất hiện trên website, giữ một số phần của website ở chế độ riêng tư, giữ các trang kết quả tìm kiếm nội bộ không hiển thị SERP

Chỉ định vị trí sitemap, ngăn chặn các công cụ tìm kiếm lập chỉ mục (index) một số tệp và link nhất định trên website. Ngăn chặn việc máy chủ bị quá tải khi các trình dữ liệu tải nhiều nội dung cùng một lúc.

Những điều cần phải lưu ý khi tạo file Robot.txt

Những điều cần phải lưu ý khi tạo file Robot.txt

Khi các bạn đã nắm được File robots txt là gì thì khi tạo 1 file robot riêng cho website của mình thì cũng không tránh khỏi những sai sót và những lỗi cơ bản. Để tránh mắc phải những sai lầm đó các bạn nên chú ý những điều sau đây:

- Không nên chèn thêm vào những ký tự đặc biệt ngoài các cú pháp lệnh.

- Không được viết dư, hoặc thiếu khoảng trắng.

- Không chèn thêm các mã đoạn code hoặc html vào file Robot.txt

- Tên khai báo trong nội dung file Robot.txt có phân biệt chữ hoa và chữ thường.

- Không được viết chữ có dấu, ký tự lạ

- Tên file viết chữ thường như sau: robots.txt

- Để được các con bot tìm thấy file robots.txt bạn phải đặt file robots.txt trong thư mục root domain cấp cao nhất của trang web.( ví dụ: www.example.com/robots.txt )

Robots.txt thực tế rất tốt cho SEO

Hãy kiểm tra toàn bộ file robots.txt của bạn và đảm bảo rằng bạn không chặn bất kỳ phần nào của trang web mà bạn muốn xuất hiện trong các công cụ tìm kiếm.

Không chặn các thư mục CSS hoặc JS. Trong quá trình Google thu thập thông tin và lập chỉ mục có thể xem trang web như một người dùng thực và nếu các trang CSS hoặc JS hoạt động 1 đúng cách, chúng sẽ không bao giờ bị chặn.

Nếu website của bạn đang dùng WordPress thì bạn không cần phải chặn truy cập vào các thư mục wp-admin và wp-include. Vì WordPress đã thực hiện công việc này bằng thẻ meta robots, nếu bạn đã làm rồi thì cũng không sao cả.

Một điều quan trọng nữa là bạn không nên cố gắng chỉ định các quy tắc khác nhau cho mỗi bot trên công cụ tìm kiếm, nó có thể gây là sự nhầm lẫn và khó cập nhật.

Kết luận

Bạn không phải tốn nhiều thời gian, công sức để cấu hình hoặc là thử nghiệm file robots.txt của mình. Nếu bạn muốn thử nghiệm thì điều quan trọng là phải thông qua Công cụ Quản trị trang web của Google để chắc chắn 1 điều bạn không chặn trình thu thập thông tin của công cụ tìm kiếm đến trang web của bạn. Qua bài viết này mình đã giải thích rõ về File Robots txt là gì? và những ý nghĩa của nó, mong các bạn có thể áp dụng vào công việc của mình nhé!

Những điều cần phải lưu ý khi tạo file Robot.txt

Những điều cần phải lưu ý khi tạo file Robot.txt